《LLM 二次方成本诅咒 × WAO 破解机制》技术白皮书页。这是**“最硬的一页”**:给 CTO 看不虚,给 CFO 看能

LLM 二次方成本诅咒 × WAO 破解机制

《LLM 二次方成本诅咒 × WAO 破解机制》技术白皮书页。

这是**“最硬的一页”**:给 CTO 看不虚,给 CFO 看能算账,给投资人看能定价。

定位为:Whitepaper · Core Economics & Systems Page。

LLM 二次方成本诅咒 × WAO 破解机制

How WAO-64-CORE-PROTOCOL Breaks the O(N²) Inference Cost Wall

一、执行摘要(Executive Summary|一段话定生死)

LLM 的核心商业瓶颈不是模型能力,而是推理阶段的二次方成本曲线。 WAO-64-CORE-PROTOCOL 通过“语义状态编译 + 状态迁移执行”, 将 AGI 系统的运行复杂度从 O(N²) 降维为 O(N) / O(log N), 使 2% 协议授权费从“治理溢价”转化为: —— 成本对冲 + 规模解锁 + 利润保护。

二、问题定义:什么是 LLM 的“二次方成本诅咒”

1. 工程现实(不是理论)

在真实企业系统中,LLM 推理成本主要由以下因素决定:

- 上下文长度(Context Length)

- Agent 数量(Multi-Agent)

- 多轮交互(Turns)

- 实时具身决策(Embodied AI)

其核心计算结构为 注意力机制:Inference CostLLM ≈ O(N2)\text{Inference Cost}_{LLM} \;\approx\; O(N^2)Inference CostLLM≈O(N2)

其中 NNN 为 token / 交互规模。

2. 商业后果(CFO 视角)

- 场景复杂度 ↑ → 成本 平方级爆炸

- Agent 数 ↑ → 上下文拼接 ↑ → 成本失控

- 结果: 高价值场景 反而不敢规模化 推理成本成为利润天花板

三、WAO 的核心转变:不是“优化”,而是“范式切换”

关键一句话

WAO 不让系统在 token 上反复“思考”, 而是把思考提前编译为“有限、可复用的语义状态”。

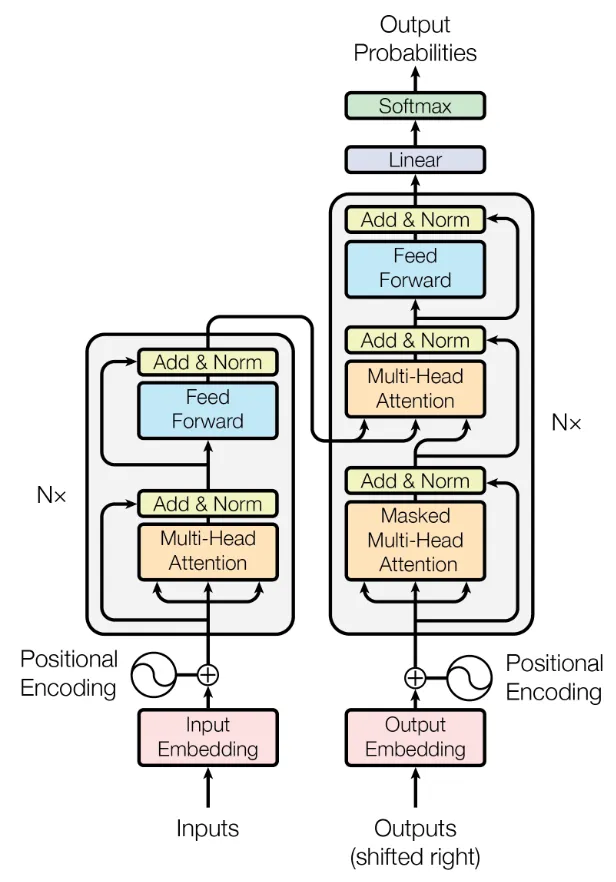

1. 计算范式对比

| 维度 | 传统 LLM 架构 | WAO-64-CORE-PROTOCOL |

|---|---|---|

| 决策载体 | Token 序列 | 语义状态(Finite State) |

| 推理方式 | 每轮重算 | 状态迁移 |

| 上下文处理 | 拼接 & 膨胀 | 状态引用 |

| 复杂度 | O(N²) | O(N) / O(log N) |

| 扩展性 | 成本爆炸 | 近线性扩展 |

四、复杂度曲线对比(核心图示)

图示解读(可直接写在图下注释)

- 红线(LLM):上下文增长 → 推理成本二次方上升

- 蓝线(WAO):状态数量增长 → 成本线性 / 次线性上升

- 拐点含义: 从某一复杂度开始, “不用 WAO = 业务不可扩展”

五、为什么 WAO 能做到这一点(技术机制)

1️⃣ 有限语义状态(Finite Semantic State Space)

- 决策不再依赖“完整历史文本”

- 而依赖: 当前状态 ID 合法迁移规则

👉 历史被“引用”,而不是被“重复计算”。

2️⃣ 状态迁移 ≠ 文本生成DecisionWAO:=T(si,a)→si+1\text{Decision}_{WAO} := T(s_i, a) \rightarrow s_{i+1}DecisionWAO:=T(si,a)→si+1

- 无需注意力矩阵

- 无需上下文拼接

- 可缓存、可复用、可审计

3️⃣ LLM 角色被“卸载”

在 WAO 架构中:

- LLM = 语言 UI / 解释器

- 不再承担: 长期记忆 多 Agent 协调 决策一致性

👉 这是成本下降的根本原因。

六、企业级量化结论(CFO 能直接用)

一个简化但真实的判断公式

当 AGI 系统进入多 Agent / 具身机器人阶段: 不使用 WAO → 推理成本 ∝ 场景复杂度² 使用 WAO → 推理成本 ∝ 场景复杂度

因此:\text{2% 协议授权费} \;\ll\; \text{长期节省的推理 + 能源 + 资本支出}

七、把“2%”重新定义(这是最关键的一段)

没有 WAO:

- 2% 看起来像:治理溢价

有了 WAO(克服二次方诅咒):

2% = 成本对冲(对抗 O(N²) 推理爆炸) 规模解锁(Agent / 具身机器人可指数扩展) 利润保护(推理不再吞噬毛利)

📌 这是整个 WAO / NETIZEN / WAO-DAO 经济模型中最“硬”的一条。

八、白皮书级一句话结论(可反复引用)

WAO-64-CORE-PROTOCOL 的价值, 不在于让 AGI“更聪明”, 而在于让 AGI“不再指数级烧钱”。

Like 0

Favorites 0

Comments (0)

No comments